ED-4.2-m08-1.0-Slajd14

Przykład (7)

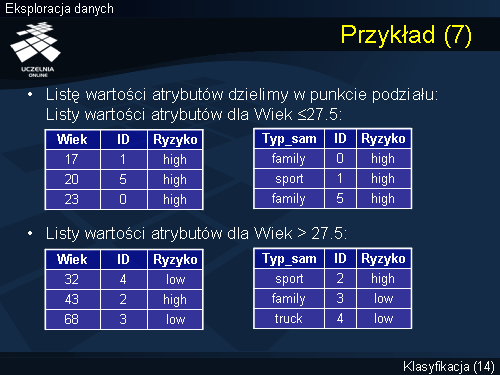

Jeżeli założymy, że minimalna liczba elementów partycji, która powoduje kontynuację wykonywania procedury Partition wynosi 5, wówczas po utworzeniu wierzchołka korzenia drzewa decyzyjnego procedura Partition zostaje zatrzymana i ostateczne drzewo decyzyjne skonstruowane przez algorytm Sprint będzie miało postać taką jak przedstawiona na poprzednim slajdzie. Jeżeli jednakże założymy, że minimalna liczba elementów partycji, która powoduje kontynuację wykonywania procedury Partition wynosi 3, wówczas konstrukcja drzewa decyzyjnego w rozważanym przez nas przykładzie będzie kontynuowana. W takim wypadku lista rekordów zbioru treningowego jest dzielona w punkcie podziału i uzyskujemy dwa zbiory rekordów, partycję pierwszą, która spełnia predykat Wiek <= 27.5, oraz partycję drugą, która spełnia warunek Wiek > 27.5. Przypomnijmy, że pierwsza partycja jest partycją czystą, w związku z tym tworzymy wierzchołek liścia, któremu przypisujemy etykietę klasy Ryzyko = High. Natomiast dla partycji drugiej uruchamiana jest procedura Partition, która ponownie dla każdego atrybutu deskryptora ocenia jakość wszystkich możliwych punktów podziału. Ponieważ lista atrybutów deskryptorów składa się w naszym przypadku tylko z dwóch atrybutów (Wiek oraz Typ_samochodu). Dodatkowo atrybut Wiek został wykorzystany do konstrukcji pierwszego wierzchołka drzewa decyzyjnego, to pozostaje nam do analizy tylko i wyłącznie atrybut Typ_samochodu, dla którego musimy dokonać oszacowania jakości wszystkich możliwych punktów podziału.