Teoria informacji/TI Wykład 5: Różnice pomiędzy wersjami

Nie podano opisu zmian |

poprawka \and na \wedge |

||

| Linia 13: | Linia 13: | ||

''Umowa notacyjna'' Jeśli zmienne losowe o których mowa będą wynikały z kontekstu, często będziemy omijać zapis <math>X=a</math> i pisać po prostu ''a''. Przykładowo będziemy pisać ''p(x|y) '' zamiast <math>p(X=x|Y=y)</math>, <math>p(x \ | ''Umowa notacyjna'' Jeśli zmienne losowe o których mowa będą wynikały z kontekstu, często będziemy omijać zapis <math>X=a</math> i pisać po prostu ''a''. Przykładowo będziemy pisać ''p(x|y) '' zamiast <math>p(X=x|Y=y)</math>, <math>p(x \wedge y)</math> zamiast <math>p((X=x) \wedge (Y=y))</math> itp. | ||

| Linia 35: | Linia 35: | ||

<center><math>(A,B) (s) = \left( A(s), B(s) \right)</math></center> | <center><math>(A,B) (s) = \left( A(s), B(s) \right)</math></center> | ||

Prawdopodobieństwo że ta zmienna przyjmie wartość ''(a,b)'' wynosi <math>p \left( (A,B) = (a,b) \right) = p \left( (A = a) \wedge (B = b) \right)</math>, co zapisujemy w skrócie jako <math>p(a \ | Prawdopodobieństwo że ta zmienna przyjmie wartość ''(a,b)'' wynosi <math>p \left( (A,B) = (a,b) \right) = p \left( (A = a) \wedge (B = b) \right)</math>, co zapisujemy w skrócie jako <math>p(a \wedge b)</math>. To prawdopodobieństwo w ogólności jest inne niż <math>p(a) \cdot p(b)</math>. Jeśli dla dowolnych <math>a \in {\mathcal A}, b \in {\mathcal B}</math> | ||

<math>p(a \ | <math>p(a \wedge b) = p(a) \cdot p(b)</math>, mówimy że zmienne losowe ''A'' i ''B'' są niezależne. | ||

Entropia <math>H_r(A,B)</math> wprost z definicji wynosi | Entropia <math>H_r(A,B)</math> wprost z definicji wynosi | ||

| Linia 67: | Linia 67: | ||

</math></center> | </math></center> | ||

Ważne że powyższe wyrażenie jest dobrze zdefiniowane, bo gdy <math>p(a)=0</math> lub <math>p(b)=0</math>, to również <math>p(a \ | Ważne że powyższe wyrażenie jest dobrze zdefiniowane, bo gdy <math>p(a)=0</math> lub <math>p(b)=0</math>, to również <math>p(a \wedge b)=0</math>. | ||

Oznaczmy chwilowo | Oznaczmy chwilowo | ||

| Linia 75: | Linia 75: | ||

<center><math>\sum_{ (a,b) \in ({\mathcal A} \times {\mathcal B})^{+}} p( a \wedge b) = \sum_{ (a,b) \in ({\mathcal A} \times {\mathcal B})^{+}} p(a)\cdot p(b)= 1</math>.</center> | <center><math>\sum_{ (a,b) \in ({\mathcal A} \times {\mathcal B})^{+}} p( a \wedge b) = \sum_{ (a,b) \in ({\mathcal A} \times {\mathcal B})^{+}} p(a)\cdot p(b)= 1</math>.</center> | ||

Używając [[Teoria informacji/TI Wykład 2#złoty|Złotego Lematu]] dla <math>x=p(a \ | Używając [[Teoria informacji/TI Wykład 2#złoty|Złotego Lematu]] dla <math>x=p(a \wedge b)</math>, <math>y=p(a)\cdot p(b)</math> dla wszystkich <math>(a,b) \in ({\mathcal A} \times {\mathcal B})^{+}</math> otrzymujemy | ||

<center><math>\aligned | <center><math>\aligned | ||

H_r (A,B) & = \sum_{ (a,b) \in ({\mathcal A} \times {\mathcal B})^{+}} p( a \wedge b) \log_r \frac{1}{p( a \wedge b)}\\ | H_r (A,B) & = \sum_{ (a,b) \in ({\mathcal A} \times {\mathcal B})^{+}} p( a \wedge b) \log_r \frac{1}{p( a \wedge b)}\\ | ||

| Linia 83: | Linia 83: | ||

</math></center> | </math></center> | ||

Dodatkowo równość zachodzi wyłącznie gdy <math>p(a \ | Dodatkowo równość zachodzi wyłącznie gdy <math>p(a \wedge b) = p(a) \cdot p(b)</math> dla wszystkich <math> (a,b) \in ({\mathcal A} \times {\mathcal B})^{+}</math> (czyli w ogóle dla wszystkich <math> a \in {\mathcal A}, b \in {\mathcal B}</math>. W drugą stronę, wiemy już że niezależność A i B implikuje tutaj równość.}} | ||

| Linia 156: | Linia 156: | ||

W powyższym wyliczeniu sumy po a i b obejmują te wartości, dla których odpowiednie prawdopodobieństwa zależne są zdefiniowane (<math>p(x|y)</math> nie jest określone jeśli <math>p(y)=0</math>). | W powyższym wyliczeniu sumy po a i b obejmują te wartości, dla których odpowiednie prawdopodobieństwa zależne są zdefiniowane (<math>p(x|y)</math> nie jest określone jeśli <math>p(y)=0</math>). | ||

Używamy tu łatwego faktu, że jeśli <math>p(a \ | Używamy tu łatwego faktu, że jeśli <math>p(a \wedge b|c)>0</math>, to | ||

<center><math>p ( a \wedge b | c) = \frac{ p(a \wedge b \wedge c)}{p( c)}= \frac{ p(a \wedge b \wedge c)}{ p (b \wedge c)} \cdot \frac{p (b \wedge c)}{p(c)} = p (a | b \wedge c) \cdot p(b|c)</math></center> | <center><math>p ( a \wedge b | c) = \frac{ p(a \wedge b \wedge c)}{p( c)}= \frac{ p(a \wedge b \wedge c)}{ p (b \wedge c)} \cdot \frac{p (b \wedge c)}{p(c)} = p (a | b \wedge c) \cdot p(b|c)</math></center> | ||

Wersja z 11:58, 1 wrz 2006

Entropia warunkowa i informacja wzajemna

Definicja [Entropia zmiennej losowej]

Jeśli jest zmienną losową, określamy jej entropię jako

Innymi słowy, jest równe wartości oczekiwanej

gdzie p(X) jest zmienną losową na S zdefiniowaną jako

Umowa notacyjna Jeśli zmienne losowe o których mowa będą wynikały z kontekstu, często będziemy omijać zapis i pisać po prostu a. Przykładowo będziemy pisać p(x|y) zamiast , zamiast itp.

Definicja [Entropia warunkowa]

i ogólnie

Zauważmy że jeśli A i B są niezależne, to w powyższej formule a więc . Z drugiej strony . Ogólnie dla dowolnej funkcji mamy

Rzeczywiście, jeśli to , i w konsekwencji .

Entropia łączna

Będziemy również rozważać pary (A,B) jako jedną zmienną losową ,

Prawdopodobieństwo że ta zmienna przyjmie wartość (a,b) wynosi , co zapisujemy w skrócie jako . To prawdopodobieństwo w ogólności jest inne niż . Jeśli dla dowolnych , mówimy że zmienne losowe A i B są niezależne.

Entropia wprost z definicji wynosi

Jeśli A i B są niezależne, to

Z liniowości wartości oczekiwanej dostajemy wtedy

W ogólnym przypadku możemy udowodnić:

Twierdzenie

Dowód

i .

Ważne że powyższe wyrażenie jest dobrze zdefiniowane, bo gdy lub , to również .

Oznaczmy chwilowo

Mamy wtedy

Używając Złotego Lematu dla , dla wszystkich otrzymujemy

Definicja [Informacja]

Komentarz Powyższę definicję łatwo zrozumieć w odniesieniu do Gry w 20 pytań. Przypuścmy że mamy zidentyfikować obiekt który jest parą (a,b) gdzie a i b są wartościami zmiennych losowych A i B. Jeśli A i B są niezależne, najlepsze co możemy zrobić to zidentyfikować niezależnie a i b. Tym samym gramy w dwie niezależne gry „pytania o a” i „pytania o b” (co odpowiada równości ). Jeśli jednak A i B są zależne, możemy wykorzystać tę wzajemną informację do zmniejszenia liczby pytań.

Dla zwiększenia czytelności tekstu, od tej pory będziemy zwykle omijać dolny indeks r, pisząc H, I, itp. Wszędzie tam gdzie nie napisano inaczej, wszystkie twierdzenia odnoszą się do przypadku dowolnego . Bez utraty ogólności czytelnik może założyć r=2.

Komentarz Przekształcając definicję informacji analogicznie jak w ostatnim dowodzie, otrzymujemy:

W takiej postaci widać że informacja jest pewną miarą odległości pomiędzy faktycznym rozkładem zmiennej (A;B), a jej rozkładem gdyby A i B były niezależne.

Warto zauważyć że powyższa suma jest nieujemna, choć niektóre składniki mogą być ujemne.

Istnieje odpowiednik równości , który stosuje się do zmiennych zależnych:

Fakt [Zasada łańcuchowa]

Dowód

Używając zasady łańcuchowej, możemy wyliczać informację na różne sposoby:

Kolejną rzeczą jaką możemy zauważyć to

Łatwo możemy też uogólnić zasadę łańcuchową na przypadek zmiennych

(przyjmujemy konwencję )

Bardziej wyrafinowane uogólnienie możemy uzyskać stosując entropię warunkową:

Fakt [Warunkowa zasada łańcuchowa]

Dowód

W powyższym wyliczeniu sumy po a i b obejmują te wartości, dla których odpowiednie prawdopodobieństwa zależne są zdefiniowane ( nie jest określone jeśli ).

Używamy tu łatwego faktu, że jeśli , to

Uśredniając po dostajemy:

Definicja [Informacja warunkowa]

Definiujemy informację wzajemną A i B warunkowaną przez C jako

I wreszcie, informację wzajemną A, B i C definiujemy jako:

Łatwo sprawdzimy że ta definicja jest rzeczywiście symetryczna, tzn nie zależy od kolejności A, B i C:

Należy jednak pamiętać że w przeciwieństwie do i , zdefiniowana powyżej może mieć ujemną wartość.

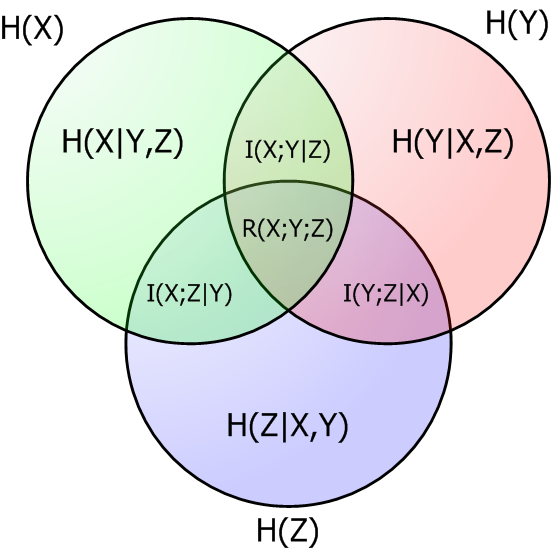

Zależności pomiędzy wartościami itd. można przedstawić w postaci diagramu: