|

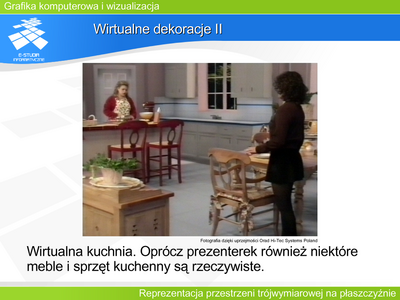

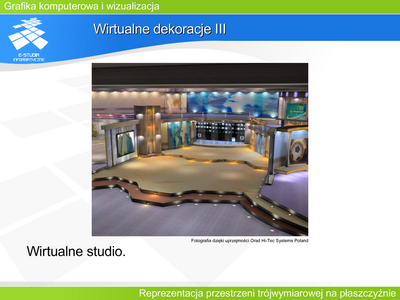

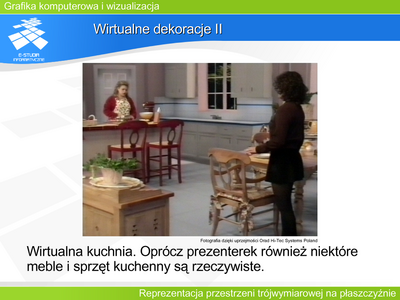

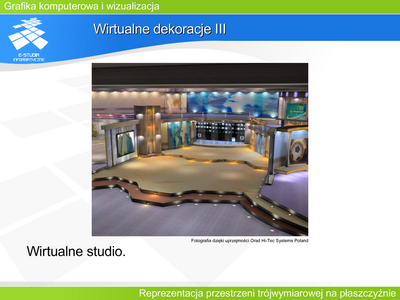

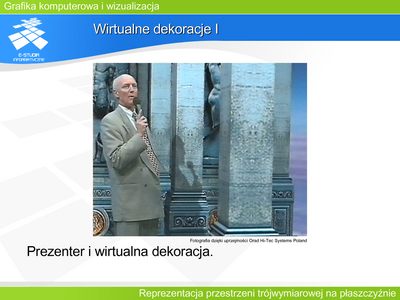

Umieszczenie w wyimaginowanym świecie wirtualnej kamery, która daje możliwość manipulacji zgodnie ze znanymi realiami pozwala łączyć obrazy rzeczywiste z wirtualnymi. Przykładem takiego „graficznego świata” jest wirtualne studio, coraz częściej wykorzystywane przez stacje telewizyjne. Zamiast budować dekoracje do nowego programu, tworzy się je za pomocą grafiki komputerowej. Program powstaje w ten sposób, że niezależnie prowadzi się dwie rejestracje. Rejestrację prezenterów (lub innych osób występujących) rzeczywistą kamerą oraz „rejestrację” wirtualnej dekoracji wirtualną kamerą. Obie kamery mają odpowiednio zgodne parametry funkcjonalne oraz w pełni zsynchronizowane ruchy. Oba obrazy składa się następnie techniką blue boxu, tworząc to, co potem oglądamy na ekranie. Oczywiście możliwe są dowolne warianty łączenia elementów rzeczywistych i wirtualnych łącznie z dowolnym zasłanianiem jednych przez drugie.

Technika ta pozwala zaoszczędzić nie tylko pieniądze, czas i materiały przy tworzeniu dekoracji, pozwala też „zaoszczędzić” powierzchnię studia telewizyjnego, gdzie odbywa się realizacja programu. Oglądając program wierzymy w masywne dekoracje rozstawione na olbrzymiej przestrzeni, a w rzeczywistości prezenter może siedzieć w ciasnym wnętrzu.

Zainteresowanych tematem wirtualnego studia zachęcamy do przeczytania pracy: Wojdała A., Gruszewski M., Olech R.: Real-Time Shadow Casting in Virtual Studio. Machine Graphics & Vision IPI PAN vol. 9, nos.1/2, 2000, ss.315-329.

|