MN08

Wielkie układy równań liniowych

Wraz z coraz większymi modelami pojawiającymi się w praktyce obliczeniowej, coraz częściej zachodzi potrzeba rozwiązywania zadań algebry liniowej, w której macierze są co prawda wielkiego wymiaru, ale najczęściej rozrzedzone, to znaczy jest w nich bardzo dużo zer. Bardzo często zdarza się, że macierz wymiaru ma tylko niezerowych elementów. Wykorzytanie tej specyficznej własności macierzy nie tylko prowadzi do algorytmów istotnie szybszych od ich analogów dla macierzy gęstych (to znaczy takich, które (w założeniu) mają elementów), ale wręcz są jedynym sposobem na to, by niektóre zadania w ogóle stały się rozwiązywalne przy obecnym stanie techniki obliczeniowej!

Jednym ze szczególnie ważnych źródeł układów równań z macierzami rozrzedzonymi są np. równania różniczkowe cząstkowe (a więc np. modele pogody, naprężeń w konstrukcji samochodu, przenikania kosmetyków do głębszych warstw skóry, itp.).

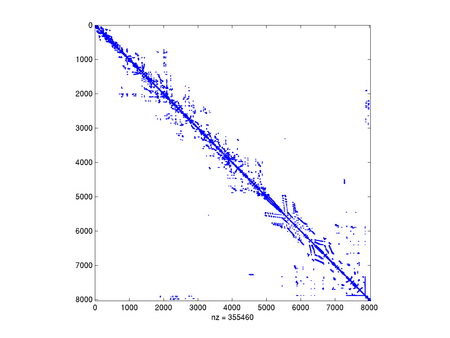

Przykład: Macierz z kolekcji Boeinga

Macierz sztywności dla modelu silnika lotniczego wygenerowana swego czasu w zakładach Boeinga pochodzi z [http://www.cise.ufl.edu/research/sparse/matrices/Boeing kolekcji Tima Davisa] (autora bardzo dobrego solvera równań liniowych z macierzami rzadkimi). Jest to mała macierz, wymiaru 8032 (w kolekcji spotkasz równania z milionem i więcej niewiadomych).

Modele wielostanowych systemów kolejkowych (np. routera obsługującego wiele komputerów) także prowadzą do gigantycznych układów równań z macierzami rozrzedzonymi o specyficznej strukturze.

Z reguły zadania liniowe wielkiego wymiaru będą miały strukturę macierzy rozrzedzonej, gdyż najczęściej związki pomiędzy niewiadomymi w równaniu nie dotyczą wszystkich, tylko wybranej grupy.

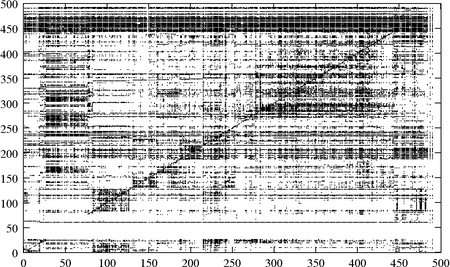

Przykład: Macierz MBEACXC

Dane pochodzą z serwisu MatrixMarket. Jest to niezbyt duża macierz, wymiaru , niesymetryczna, o elementach rzeczywistych. Źródłem tej macierzy jest pewien model ekonomiczny.

Tylko pozornie macierz ta wydaje się dość gęsta, w rzeczywistości jej współczynnik wypełnienia wynosi około 20 procent.

Formaty macierzy rzadkich

Zacznijmy od sposobu przechowywania macierzy rozrzedzonych. Naturalnie, nie ma sensu przechowywać wszystkich zerowych jej elementów: wystarczy ograniczyć się do zachowania tych niezerowych! W ten sposób zmniejszamy zarówno wymagania pamięciowe, jak i liczbę operacji zmiennoprzecinkowych potrzebnych do prowadzenia działań na macierzy (np. w przypadku mnożenia macierzy przez wektor, nie będziemy mnożyć przez zera!).

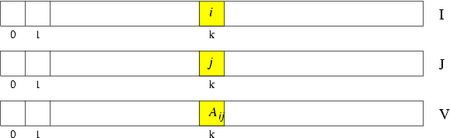

Format współrzędnych (AIJ)

Do zapamiętania macierzy

wymiaru o niezerowych elementów wykorzystujemy trzy wektory: I,

J --- oba typu int --- oraz V, typu double,

wszystkie o długości , przy czym

W tym formacie wprowadzane są macierze rzadkie do Octave'a i MATLABa:

A = sparse(I,J,V,N,N);

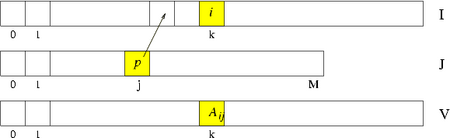

Format spakowanych kolumn (wierszy)

Format współrzędnych nie narzucał żadnego uporządkowania elementów macierzy --- można było je umieszczać w dowolnej kolejności. Narzucenie sensownego porządku mogłoby wspomóc realizację wybranych istotnych operacji na macierzy, na przykład, aby wygodnie było realizować działanie (prawostronnego) mnożenia macierzy przez wektor, wygodnie byłoby przechowywać elementy macierzy wierszami. Tak właśnie jest zorganizowany format spakowanych wierszy, Compressed Sparse Row (CSR) . Analogicznie jest zdefiniowany format spakowanych kolumn, Compressed Sparse Column (CSC) , którym zajmiemy się bliżej.

Podobnie jak w przypadku formatu współrzędnych, macierz w formacie CSC jest

przechowywana w postaci trzech wektorów: AV jest wektorem typu

double o długości , zawierającym kolejne niezerowe elementy

macierzy wpisywane kolumnami, AI jest wektorem typu int

o długości , zawierającym numery wierszy macierzy odpowiadających

elementom z AV. Natomiast zamiast tablicy J, jak to było w

formacie współrzędnych, mamy krótszy wektor typu int, AP, o

długości zawierający na -tym miejscu indeks pozycji w AV, od

którego rozpoczynają się w AV elementy -tej kolumny macierzy .

Mamy więc zależność, przy założeniu, że ,

Taki (z drobnymi modyfikacjami) format macierzy wykorzystują np. pakiety ARPACK i UMFPACK.

Format diagonalny

Znacznie mniej uniwersalny niż poprzednie i dlatego rzadziej spotykany. Kolejne diagonale macierzy przechowujemy w kolejnych wierszach macierzy , gdzie jest liczbą niezerowych diagonal w .

Szczególnie wygodny do reprezentacji macierzy taśmowych. Wykorzystywany m.in.

przez funkcję LAPACKa DGBSV służącą rozwiązywaniu równań z macierzami

taśmowymi.

Macierze specjalne

Zajmiemy się teraz zadaniem rozwiązywania układu równań liniowych

ale w sytuacji, gdy macierz jest rozrzedzona i dużego wymiaru. Dokonamy przeglądu kilku rodzajów algorytmów mających na celu wykorzystanie rozrzedzenia macierzy dla obniżenia kosztu wyznaczenia rozwiązania układu.

Należy pamiętać, że z reguły najlepsze wyniki uzyskuje się, gdy konkretny algorytm dobierze się do konkretnej macierzy. W zastosowaniach pojawiają się m.in. macierze rzadkie o bardzo szczególnej strukturze, dla nich warto stosować wyspecjalizowane algorytmy.

Macierze taśmowe

Macierz taka, że dla , , nazywamy macierzą taśmową z rozstępem , o szerokości pasma .

Łatwo sprawdzić, że algorytm eliminacji Gaussa (bez wyboru elementu głównego) nie spowoduje dodatkowego wypełnienia w takiej macierzy (a więc da się wykonać w miejscu). W przypadku konieczności wyboru elementu głównego, pesymistyczne oszacowanie rozstępu macierzy rozkładu LU jest równe --- tak więc, dla niezbyt dużych wciąż wynikowa macierz jest taśmowa.

W szczególności, gdy macierz jest taśmowa z pasmem o rozstępie i jednocześnie diagonalnie dominująca, wtedy rozkład LU takiej macierzy da się wykonać w miejscu kosztem czyli liniowym.

W LAPACKu zaimplementowano szybki solver równań z macierzami taśmowymi,

DGBSV wymagający skądinąd specjalnego sposobu

przechowywania macierzy wykorzystyjącego format diagonalny.

Macierze trójdiagonalne

Szczególnym przypadkiem macierzy taśmowych są macierze trójdiagonalne, tzn. taśmowe o rozstępie :

Zadanie rozwiązywania równań z taką macierzą

jest tak często spotykane, że warto przytoczyć algorytm w całej okazałości --- popularnie zwany algorytmem przeganiania.

Zacznijmy jednak od stwierdzenia, kiedy taka macierz nie wymaga wyboru elementu głównego:

Stwierdzenie

Jeśli macierz ma słabo dominującą przekątną, tzn.

() i przynajmniej dla jednego indeksu "" mamy powyżej ostrą nierówność "", to algorytm przeganiania jest wykonalny bez przestawień wierszy. Ponadto wymaga on operacji arytmetycznych, a więc jest prawie optymalny.

Algorytm Metoda przeganiania

<math>\displaystyle d_1</math> = <math>\displaystyle a_1</math>;

<math>\displaystyle f_1</math> = <math>\displaystyle e_1</math>;

for (i = 2; i <= N; i++)

{

<math>\displaystyle l</math> = <math>\displaystyle b_i</math>/<math>\displaystyle a_{i-1}</math>;

<math>\displaystyle d_i</math> = <math>\displaystyle a_i</math> - <math>\displaystyle l</math> * <math>\displaystyle c_{i-1}</math>;

<math>\displaystyle f_i</math> = <math>\displaystyle e_i</math> - <math>\displaystyle l</math> * <math>\displaystyle f_{i-1}</math>;

}

<math>\displaystyle x_1</math> = <math>\displaystyle f_N</math>;

for (i = N-1; i >= 1; i--)

<math>\displaystyle x_i</math> = <math>\displaystyle f_i</math> - <math>\displaystyle c_i</math> * <math>\displaystyle x_{i+1}</math>;

Metody bezpośrednie

Przykład: Strzałka Wilkinsona

Rozważmy układ równań z macierzą diagonalnie dominującą postaci

gdzie oznacza jakiś niezerowy element. Łatwo sprawdzić, że chociaż wyjściowa macierz jest rozrzedzona, to zastosowanie do niej eliminacji Gaussa powoduje, że w wyniku dostajemy gęste czynniki rozkładu.

Tymczasem wystarczy odwrócić kolejność równań i numerację niewiadomych (co dla macierzy jest równoznaczne z odwróceniem porządku wierszy i kolumn, korzystając z pewnej (jakiej?) macierzy permutacji ):

Wtedy okazuje się, że rozkład naszej macierzy nie powoduje już wypełnienia fill-in czynników rozkładu!

Właśnie na tym polega główny problem w rozwiązywaniu układów z macierzami rzadkimi metodami bezpośrednimi: maksymalnie wykorzystać rozrzedzenie macierzy tak, by czynniki rozkładu były możliwie mało wypełnione. Albowiem wiedząc to będziemy mogli ograniczyć się jedynie do fizycznego wyznaczenia wartości niezerowych elementów macierzy rozkładu. Ponadto wymagania pamięciowe algorytmu nie będą istotnie wykraczać ponad ilość pamięci potrzebnej na przechowanie danych (macierzy).

W ogólnym przypadku rozwiązanie takiego zadania jest trudne i większość algorytmów opiera się na pewnych heurystykach, które warto wspomóc wcześniejszą analizą konkretnego układu równań, który mamy rozwiązać. Najczęściej dąży się do takiego przenumerowania równań i niewiadomych, by w efekcie z góry przewidzieć, gdzie wystąpią zera w macierzach rozkładu --- i, by takich zer było jak najwięcej (by wypełnienie było jak najmniejsze)! Na architekturach z pamięcią hierarchiczną dąży się także do tego, by w trakcie rozkładu można było korzystać z BLAS3, a więc permutacje wierszy i kolumn macierzy muszą to także brać pod uwagę (tzw. metody wielofrontowe).

Stosuje się kilka strategii wyznaczania korzystnych permutacji reorderingu , z których warto wymienić

- przybliżone algorytmy minimalnego stopnia approximate minimum degree (AMD)

- techniki

podziału grafów na (prawie) rozłączne składowe (METIS).

Używają ich biblioteki takie jak UMFPACK, czy HSL.

W Octave mamy do dyspozycji także kilka procedur generujących takie permutacje,

w tym: colamd (AMD dla macierzy niesymetrycznych) oraz symamd

(AMD dla macierzy symetrycznych). Większy wybór oferuje MATLAB, jednak należy

bezwzględnie pamiętać o jednym: nie ma uniwersalnej metody reorderingu i dla

konkretnej macierzy może istnieć specjalna metoda, która da oszałamiające

rezultaty, podczas gdy standardowe podejścia nie dadzą efektu.

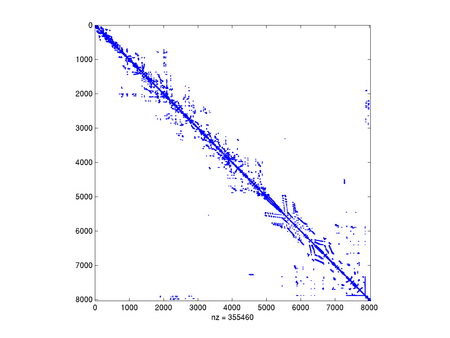

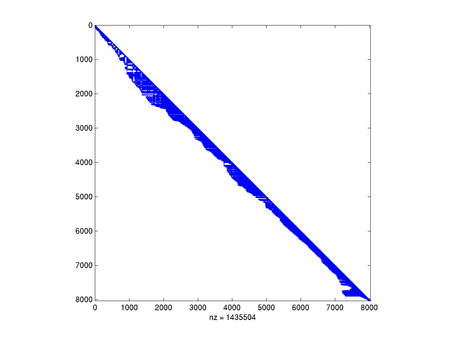

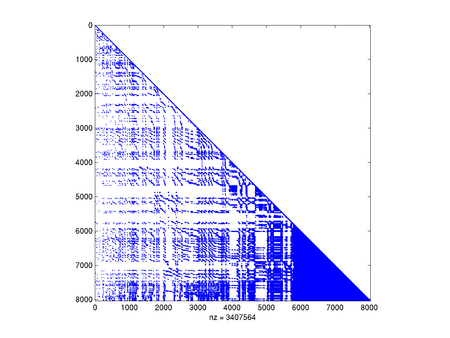

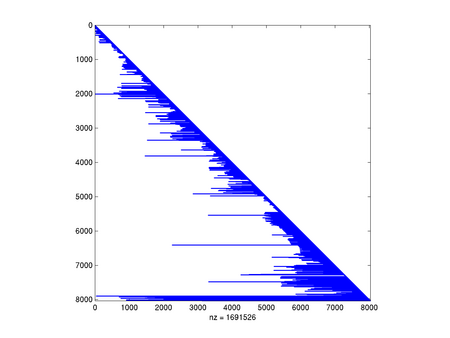

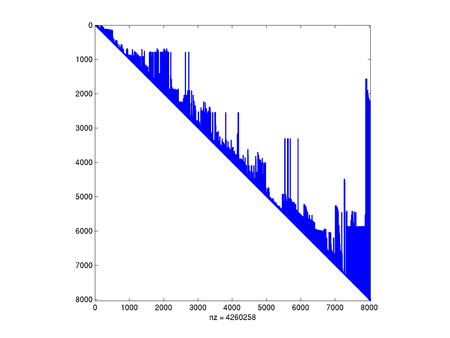

Przykład: Wypełnienie pewnej macierzy w zależności od użytego algorytmu

Rozważmy macierz pochodzącą z kolekcji Tima Davisa, dotyczącą pewnego zadania mechaniki strukturalnej jakie pojawiło się u Boeinga. Jest to macierz symetryczna, dodatnio określona, wymiaru 8032.

Jest to macierz silnie rozrzedzona, ponieważ ma tylko 355460 niezerowych elementów (czyli wypełnienie to tylko 0.5 procent).

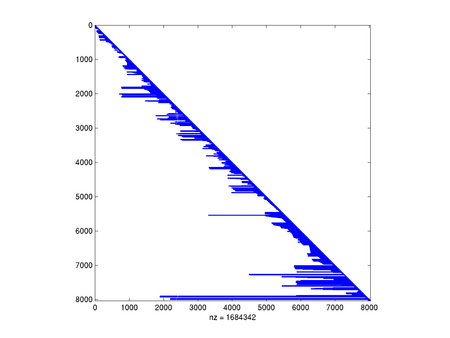

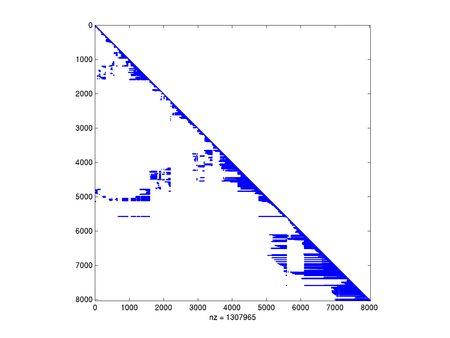

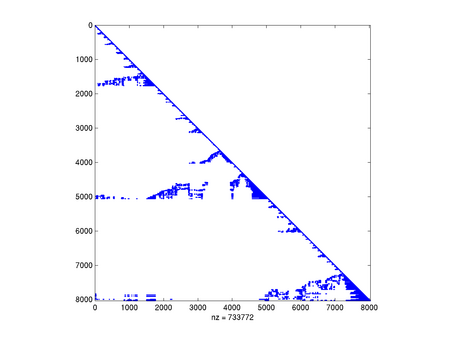

Zobaczymy, jak w zależności od użytego algorytmu permutacji kolumn i wierszy poradzi sobie algorytm rozkładu Cholesky'ego.

Na zakończenie popatrzmy, jak ważne jest spostrzeżenie symetrii macierzy:

Jak widać, w naszym przypadku standardowe algorytmy (COLAMD i SYMAMD) poradziły sobie całkiem nieźle, chociaż wypełnienie i tak znacząco wzrosło. Zapewne algorytm oparty na podziale grafu na prawie rozłączne składowe mógłby tu jeszcze lepiej zadziałać.

Stacjonarne metody iteracyjne

Gdy macierz jest rozrzedzona, mnożenie takiej macierzy przez wektor jest tanie (koszt jest proporcjonalny do liczby niezerowych elementów macierzy). Dlatego, jeśli możemy zadowolić się rozwiązaniem przybliżonym układu, a w zamian osiągnąć je tanim kosztem, warto rozważyć metody iteracyjne.

Najprostsze metody iteracyjne (najprostsze w analizie i implementacji, ale --- jak można się domyślić --- w praktyce najmniej efektywne) polegają na rozkładzie macierzy na część "łatwo odwracalną", , i "resztę", . Dokładniej, jeśli jest nieosobliwa, to równanie można zapisać jako zadanie punktu stałego

gdzie . Inaczej:

i zastosować doń Dodaj link: metodę iteracji prostej Banacha:

Takie metody nazywamy stacjonarnymi metodami iteracyjnymi.

Aby przeanalizować zbieżność takiej metody, warto rozpatrzyć przypadek ogólniejszy

dla pewnej macierzy wektora (dla stacjonarnej metody iteracyjnej, oraz ).

W tym przypadku

a stąd i z nierówności , mamy

Warunkiem dostatecznym zbieżności iteracji prostych jest więc . Okazuje się, że warunkiem koniecznym i dostatecznym zbieżności tej iteracji dla dowolnego wektora startowego jest

Tak więc, metody oparte na iteracji prostej będą zbieżne liniowo z ilorazem .

Metoda Jacobiego

Zobacz biografię

Biorąc , gdzie jest macierzą diagonalną składającą się z wyrazów stojących na głównej przekątnej macierzy , układ jest równoważny układowi

a stąd (o ile na przekątnej macierzy nie mamy zera) otrzymujemy metodę iteracyjną

,

gdzie i , zwaną metodą Jacobiego.

W metodzie Jacobiego warunek dostateczny zbieżności, , jest spełniony np. wtedy, gdy macierz ma dominującą przekątną, tzn. gdy

Rzeczywiście, ponieważ wyraz macierzy wynosi dla oraz dla , a więc

przy czym ostatnia nierówność wynika z warunku diagonalnej dominacji.

Przykład: Macierz laplasjanu

Macierz , zwana macierzą jednowymiarowego laplasjanu

pojawia się w bardzo wielu zastosowaniach, także jako podzadanie w algorytmach numerycznych. Ta macierz jest macierzą taśmową, symetryczną i dodatnio określoną, więc rozwiązanie układu równań z tą macierzą metodami bezpośrednimi jest łatwe, kosztem . Ciekawe będzie, jak poradzą sobie z nią metody iteracyjne.

Na przykład, w metodzie Jacobiego weźmiemy oraz . Obliczając normę macierzy iteracji Jacobiego dostajemy , co nie rozstrzyga jeszcze o jej (nie)zbieżności.

Okazuje się, że są gotowe wzory na wartości własne macierzy :

dla

i w konsekwencji, wartościami własnymi są liczby . Ponieważ , oraz , to metoda, choć zbieżna, dla dużych staje się zbieżna tak wolno, że w praktyce bezużyteczna.

Zaletą stacjonarnych metod iteracyjnych jest również ich prostota, przez co są one łatwe do zaprogramowania.

Metoda Gaussa--Seidela

Ciekawostką jest, że Gauss nie miał z nią nic wspólnego, a Seidel był wręcz jej przeciwnikiem...

Złożoność stacjonarnych metod iteracyjnych

Zastanówmy się teraz nad złożonością metod iteracyjnych. Ponieważ możemy jedynie znaleźć pewne przybliżenie rozwiązania dokładnego , przez złożoność metody będziemy rozumieli koszt kombinatoryczny obliczenia z zadaną dokładnością . Dla uproszczenia założymy, że medoda jest zbieżna liniowo z ilorazem . Zauważmy, że aby zredukować błąd początkowy do , wystarczy wykonać iteracji, gdzie spełnia

czyli

Liczba ta zależy więc w istotny sposób od błędu początkowego i (przede wszystkim) od współczynnika redukcji błędu , natomiast zależność od dokładności i wymiaru układu jest dużo mniej istotna (w zadaniach praktycznych -- takich jak jednowymiarowy laplasjan --- jednak często okazuje się, że... zależy od !).

Zakładając, że koszt jednej iteracji wynosi ( jest tym mniejszy, im mniejsza jest liczba niezerowych elementów macierzy ), złożoność metody jest proporcjonalna do

Stąd oczywisty wniosek, że metody iteracyjne warto stosować zamiast metod bezpośrednich w przypadku, gdy

- wymiar układu jest "duży", oraz

- macierz układu jest "rozrzedzona", tzn. ma stosunkowo niewielką liczbę elementów niezerowych, np. proporcjonalną do .

Układy o tych własnościach powstają często przy numerycznym rozwiązywaniu równań różniczkowych cząstkowych.

Metody przestrzeni Kryłowa

Zupełnie inny pomysł na realizację metody iteracyjnej przedstawiają metody przestrzeni Kryłowa, gdzie kolejne przybliżenie dobiera się w taki sposób, by minimalizowało pewną miarę błędu na podprzestrzeni Kryłowa

gdzie jest residuum na początku iteracji. W zależności od wyboru sposobu miary błędu, dostajemy inną metodę iteracyjną, takie jak CG, GMRES, PCR, BiCG, i inne. Tutaj omówimy pokrótce tylko dwie najpopularniejsze: CG i GMRES.

CG

Metoda gradientów sprzężonych conjugate gradients (CG) działa przy założeniu, że jest symetryczna i dodatnio określona.

Kolejne przybliżenie ma minimalizować błąd w normie energetycznej indukowanej przez ,

na przestrzeni afinicznej . Okazuje się (co nie jest oczywiste --- trzeba skorzystać z rozmaitych własności ortogonalności generowanych wektorów), że takie zadanie minimalizacji daje się bardzo efektywnie rozwiązać, skąd dostajemy bardzo zwarty algorytm:

Algorytm

r = b-A*x;

<math>\displaystyle \rho_{-1}</math> = 0; <math>\displaystyle \rho_0</math> = <math>\displaystyle ||r||_2^2</math>; <math>\displaystyle \beta</math> = 0; k = 1;

while <math>\displaystyle \sim</math>STOP

{

p = r + <math>\displaystyle \beta</math>*p;

w = A*p;

<math>\displaystyle \alpha</math> = <math>\displaystyle \frac{\rho_{k-1}}{p^Tw}</math>;

x = x + <math>\displaystyle \alpha</math>*p;

r = r - <math>\displaystyle \alpha</math>*w;

<math>\displaystyle \rho_k</math> = <math>\displaystyle ||r||_2^2</math>;

<math>\displaystyle \beta</math> = <math>\displaystyle \frac{\rho_{k}}{\rho_{k-1}}</math>;

k++;

}

Jak widać, całą iterację da się wykonać przechowując w pamięci tylko kilka wektorów (a nie, jak możnaby się obawiać, całą przestrzeń ), a najdroższym jej elementem jest mnożenie macierzy przez wektor.

Twierdzenie Zbieżność CG jako metody bezpośredniej

Niech będzie symetryczna i dodatnio określona. Algorytm CG znajdzie dokładne rozwiązanie po co najwyżej iteracjach.

Powyższe twierdzenie, choć teoretycznie interesujące, ma małą wartość praktyczną z dwóch powodów:

- dla bardzo dużych , wykonanie iteracji może być wciąż zbyt kosztownym zadaniem;

- ponieważ w arytmetyce skończonej precyzji ortogonalność, z której korzysta się przy wyprowadzeniu algorytmu nie jest zachowana, i w konsekwencji, po wielu iteracjach, jakość przestaje się poprawiać.

Dlatego wygodniej potraktować CG jako metodę iteracyjną. Zachodzi bowiem

Twierdzenie Zbieżność CG jako metody iteracyjnej

Po iteracjach metody CG,

gdzie .

Metoda GMRES Generalized Minimum RESidual nie wymaga ani symetrii, ani dodatniej określoności macierzy, jest więc bardziej uniwersalna, choć też bardziej kosztowna od CG.

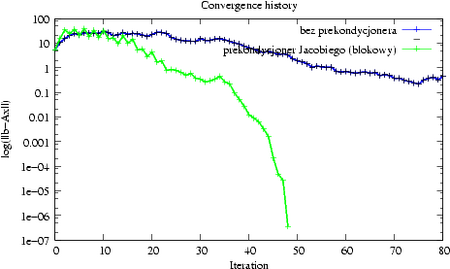

Prekondycjoning

Zbieżność wszystkich poznanych metod iteracyjnych zależy od własności spektralnych macierzy układu. Często w zastosowaniach pojawiające się macierze mają niekorzystne własności spektralne (np. bardzo duży wskaźnik uwarunkowania), przez co metody iteracyjne zbiegają na nich bardzo wolno.

Dlatego bardzo korzystne może być wstępne przetransformowanie układu

z macierzą o niekorzystnych własnościach, do układu

,

gdzie macierz ma znacznie korzystniejsze własności z punktu widzenia używanej metody iteracyjnej. Taką operację nazywamy prekondycjoningiem, a macierz --- macierzą prekondycjonera.

Aby całość miała sens, macierz prekondycjonera powinna:

- być łatwa w konstrukcji,

- być tania w mnożeniu przez wektor (głównym elementem każdej metody

iteracyjnej jest mnożenie macierzy przez wektor: ),

- macierz powinna mieć znacznie korzystniejsze własności z punktu widzenia

używanej metody iteracyjnej.

Kilka ekstremalnych propozycji na macierz prekondycjonera to (łatwa w konstrukcji i tania w mnożeniu, ale nic niestety nie polepsza) oraz (rewelacyjnie poprawia zbieżność metody iteracyjnej, dając zbieżność w jednej iteracji, ale bardzo droga w konstrukcji i mnożeniu). Widać więc, że należy poszukiwać czegoś pośredniego, co niskim kosztem przybliża działanie macierzy odwrotnej.

Dlatego jednym z powszechniej stosowanych rodzajów prekondycjonerów są te oparte na zastosowaniu jednego kroku klasycznej metody iteracyjnej.

Inne prekondycjonery stosują np. techniki tzw. niepełnego rozkładu macierzy, albo --- w specyficznych przypadkach --- tzw. metody wielosiatkowe.

Okazuje się, że zarówno CG jak i GMRES da się zaimplementować tak, by w jednej iteracji było konieczne tylko jedno mnożenie przez macierz prekondycjonera.