Architektura Komputerów/Wykład 2: Dane: Różnice pomiędzy wersjami

Z Studia Informatyczne

Przejdź do nawigacjiPrzejdź do wyszukiwania

Nie podano opisu zmian |

Nie podano opisu zmian |

||

| Linia 158: | Linia 158: | ||

|valign="top" width="500px"|[[Grafika:ASK_M2_S20.png]] | |valign="top" width="500px"|[[Grafika:ASK_M2_S20.png]] | ||

|valign="top"| | |valign="top"| | ||

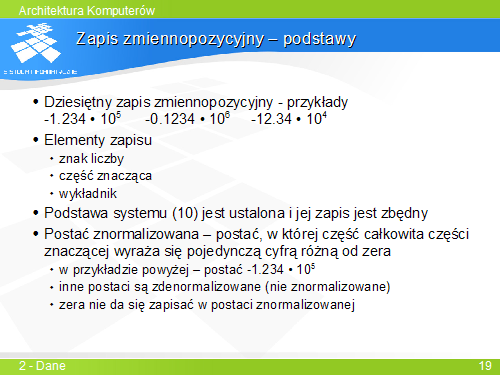

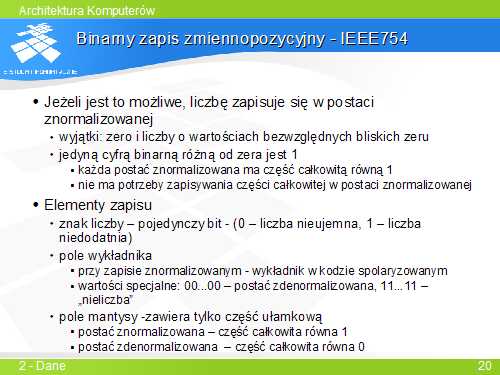

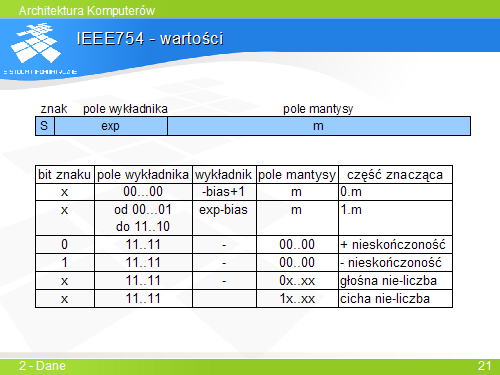

... | W przeszłości w różnych rodzinach komputerów używano różnych zapisów zmiennopozycyjnych. Od początku lat 80-tych XX wieku nastąpiła w tej dziedzinie standaryzacja. Obecnie niemal wszystkie komputery posługują się binarnym zapisem zmiennopozycyjnym zgodnym ze standardem IEEE754. | ||

Standard zakłada, że, o ile tylko jest to możliwe, liczby zapisuje się w postaci znormalizowanej. | |||

Bazą systemu jest liczba 2 – wykładnik określa potęgę liczby 2. | |||

Ponieważ w systemie binarnym jedyną cyfrą różną od zera jest jedynka, każda liczba w postaci znormalizowanej ma część cakowitą równą 1 – nie ma więc potrzeby zapisywania jej – zapisuje się tylko część ułamkową. | |||

Wykładnik jest liczbą całkowitą ze znakiem. W IEEE754 wykładnik jest zapisywany w kodzie spolaryzowanym, w którym wartość podkładu jest określona wzorcem bitowym 01....11, o liczbie bitów równej szerokości pola wykładnika. Dwie wartości pola wykładnika są zarezerwowane i oznaczają, że zapis nie reprezentuje postaci znormalizowanej. | |||

Pole wykładnika o wzorcu 00...00 oznacza zapis zdenormalizowany. Wartość wykładnika jest w tym przypadku taka sama, jak przy zapisie znormalizowanym z wzorcem wykładnika 00...01, a część całkowita części znaczącej ma wartość 0 (a nie 1 jak w postaci znormalizowanej). | |||

Pole wykładnika o wzorcu 11...11 oznacza nie-liczby – nieskończoności i wartości błędne. | |||

|} | |} | ||

<hr width="100%"> | <hr width="100%"> | ||

| Linia 170: | Linia 181: | ||

|valign="top" width="500px"|[[Grafika:ASK_M2_S22.png]] | |valign="top" width="500px"|[[Grafika:ASK_M2_S22.png]] | ||

|valign="top"| | |valign="top"| | ||

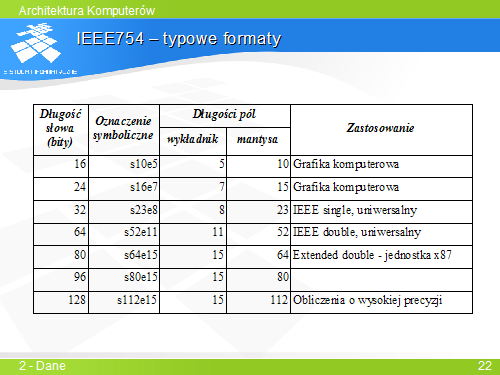

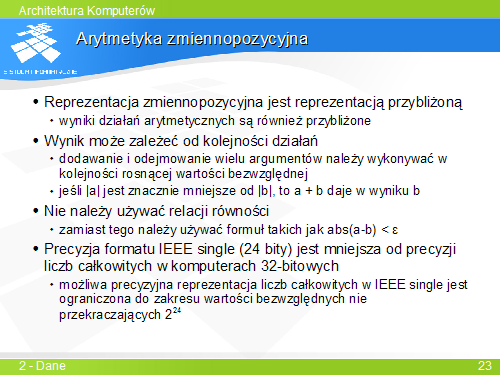

... | Podstawowym formatem jest format double – 64-bitowy. | ||

Format 32-bitowy jest używany w zastosowaniach, gdzie wymagana precyzja jest niewielka – ma on tylko 24 bity znaczące. | |||

Format 80-bitowy był używany w starszych jednostkach zmiennopozycyjnych procesorów rodziny x86. Obecnie wychodzi on z użycia. | |||

Format 128-bitowy jest formatem „przyszłościowym” dla liczb o dużej precyzji. | |||

W grafice komputerowej używa się niekiedy formatów krótszych, o mniejszej precyzji – 16- i 24-bitowego. | |||

|} | |} | ||

<hr width="100%"> | <hr width="100%"> | ||

Wersja z 11:18, 5 paź 2006

|

... |

|

... |

|

... |

|

... |

|

... |

|

... |

|

... |

|

... |

|

... |

|

... |

|

... |

|

... |

|

... |

|

... |

|

... |

|

... |

|

... |